GPT-5.4 到底变强了多少?三大核心能力+电脑操控Codex上手实测!

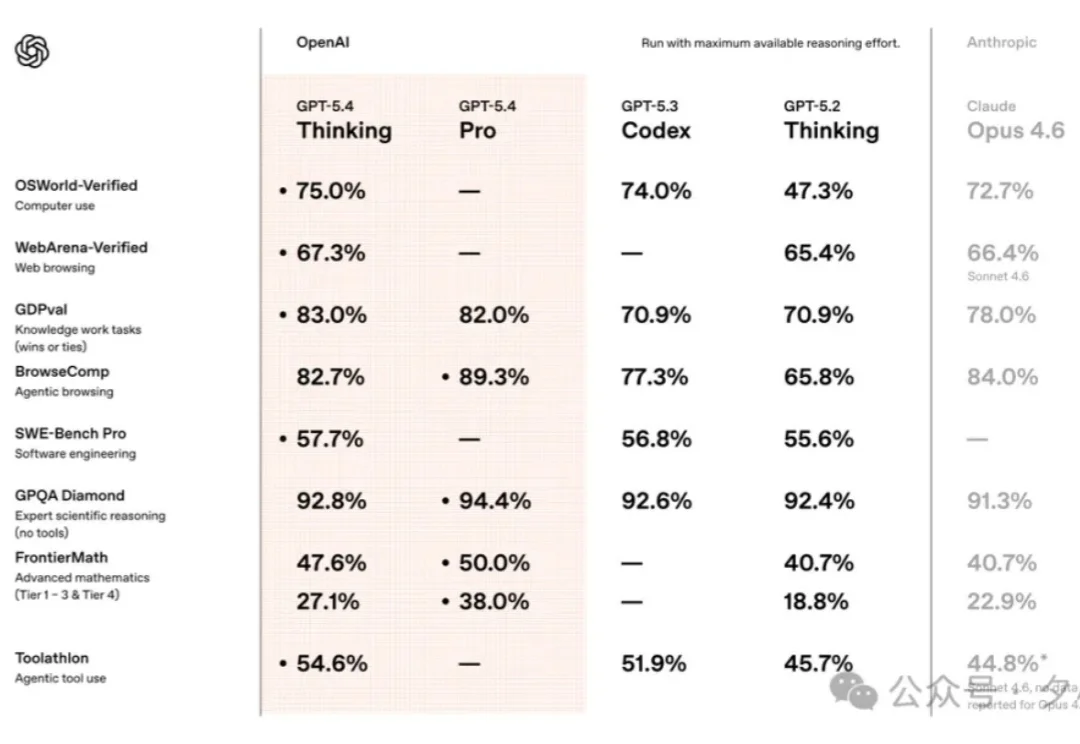

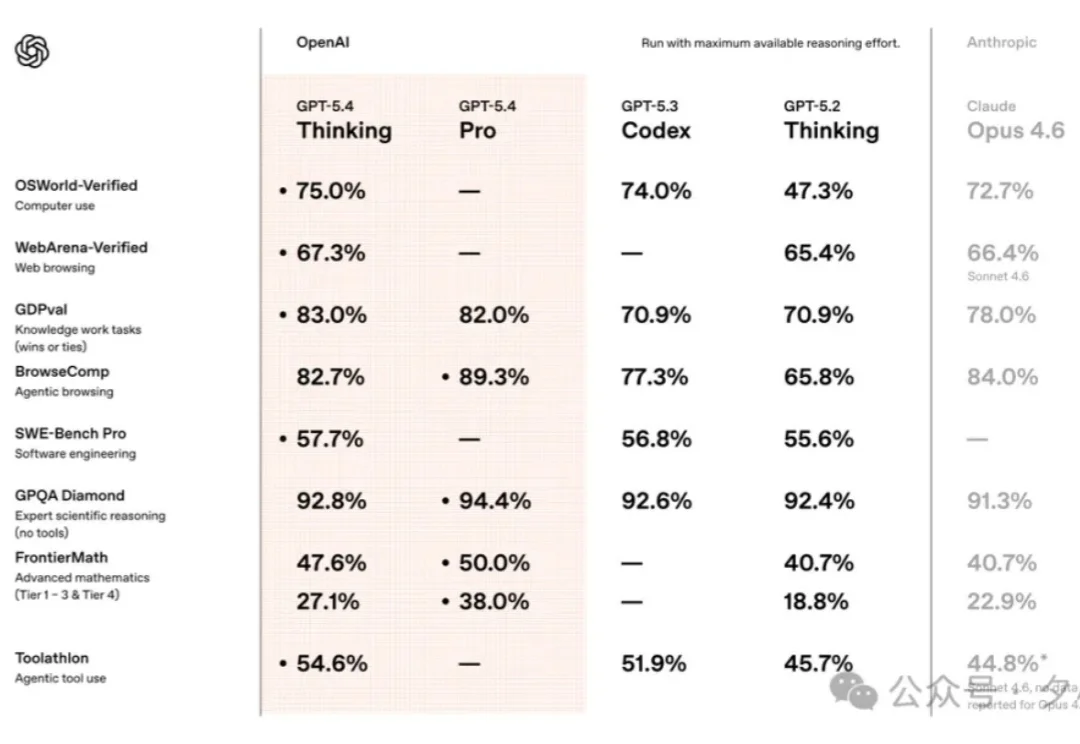

GPT-5.4 到底变强了多少?三大核心能力+电脑操控Codex上手实测!上周,GPT-5.4 发了。意图非常明显,直指 Claude Opus4.6 和 Gemini 3.1 Pro。

上周,GPT-5.4 发了。意图非常明显,直指 Claude Opus4.6 和 Gemini 3.1 Pro。

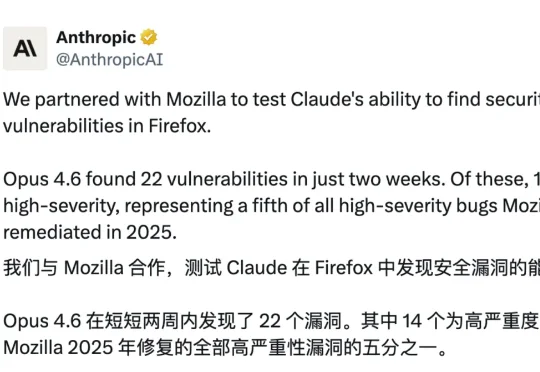

近日,Anthropic 公布了一组惊人的数字,在与 Mozilla 公司进行合作,测试旗下模型 Claude Opus 4.6 发现漏洞能力的过程中,两周内,就找出 Mozilla 公司「火狐」(Firefox)浏览器中 22 个不同的漏洞,其中 14 个是「高危漏洞」级别,而这几乎是 Mozilla 2025 年修复的全部「高危漏洞」的五分之一。

OpenAI深夜突袭,GPT-5.4新王炸场!一夜之间,直接粉碎了Gemini 3.1 Pro和Claude Opus 4.6的神话。这也是头一次,ChatGPT拥有真正「原生电脑使用」能力,办公效率直接拉满。而真正恐怖的地方在于,每一个维度上它都没有短板。

在AI自主挖洞这块试金石上,国产安全智能体完成了一次“溢出式”对标。最近,Anthropic官方披露了Claude Code Security(基于最新的Claude Opus 4.6模型)在实际项目中的战果:

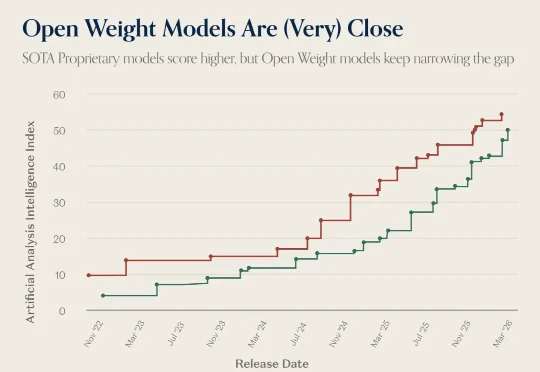

a16z 昨天发了一张图,把 GLM-5 和 Claude Opus 4.6 并排标注在 Artificial Analysis Intelligence Index 的时间线上。原文的说法是: A proprietary model (Claude Opus 4.6) is still the 'most intelligent,' but the gap between

开源模型新王 MiniMax M2.5 震撼降临:M2.5 编码性能逼平 Claude Opus 4.6,价格却只有 1/20;1 美金 / 小时,这种尺寸和性能的模型,才能在算力短缺的时代不降智不卡顿,持续提供最好体验,成为最终王者!

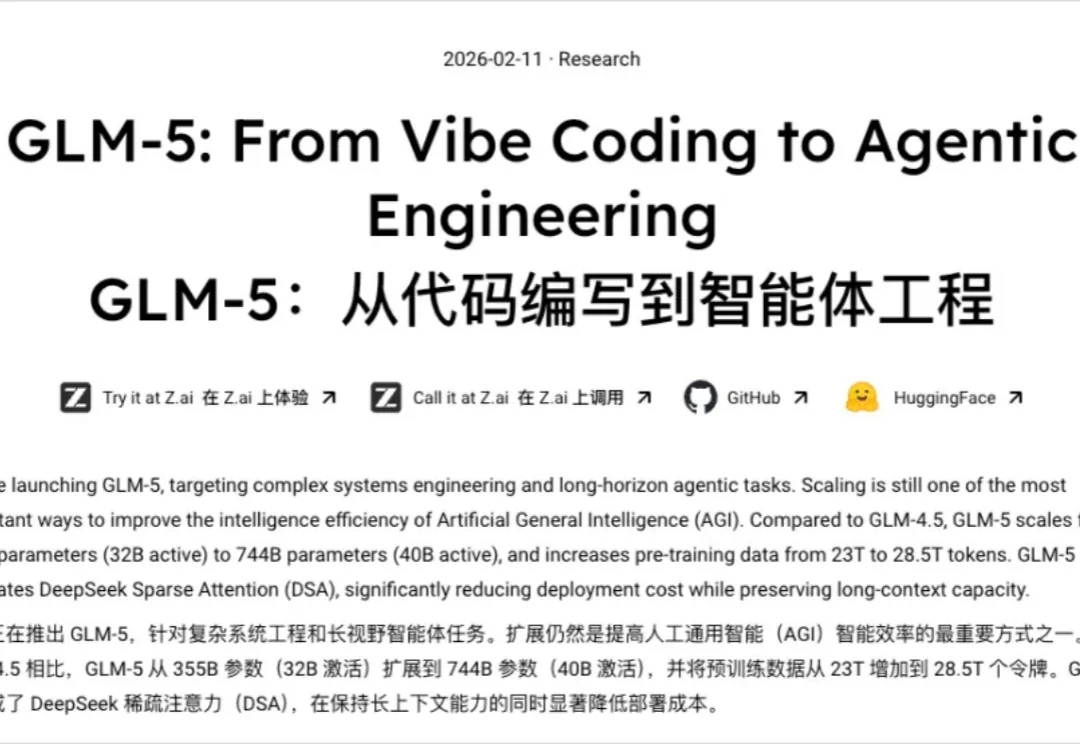

深夜,GLM-5来了。

2月11日深夜,智谱AI官宣新一代旗舰大模型GLM-5。之前在OpenRouter上神秘出现的"Pony Alpha",身份终于揭晓。据DoNews报道:Pony Alpha就是GLM-5的低调测试版。

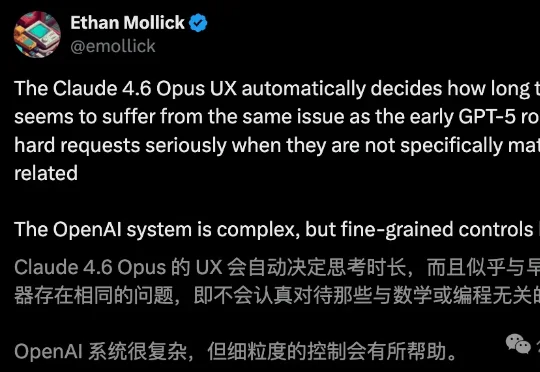

Claude,堪称AI界「老油条」。这不,沃顿商学院Ethan Mollick教授发现,Claude Opus 4.6会自主决定「思考」时间。只要不涉及编程、数学的任务,哪怕是再难的问题,干活主打一个「偷工减料」。

一睁眼,Anthropic上新模型,让Claude Opus 4.6来给您拜!年!了!